视觉中国供图

□ 科普时报记者 陈 杰

AI大模型的热度,已然开始从产业向日常生活渗透,并引起不小的舆论旋涡。近日,网友指出国内某智能办软件有拿用户数据“投喂”AI之嫌,引发口水的同时,再度把公众对AI的关注转移到数据安全上。

身处智能时代,我们在使用或跟AI交互时,该如何保护自己的数据安全?我们的个人数据可以被AI产品或平台随意收集和使用吗?科普时报记者就这些公众关心的问题采访了产业相关人士及行业专家。

AI普遍缺乏“营养”

此次舆论事件,以修改引发误会的隐私政策并承诺不会拿用户文档训练AI而暂告一段落。但清华大学人工智能研究所博士、独到科技CEO张文浩告诉记者,“以用户数据训练AI,在大模型行业普遍存在。”

今年7月份,谷歌及其AI子公司DeepMind、视频会议平台Zoom均因收集用户数据用以训练和开发AI产品而引发用户强烈担忧……

“数据被比作信息时代的‘石油’,重要性不言而喻。”文渊智库研究员王超告诉记者,用于训练数据的丰富程度和质量决定了AI的优劣,也只有优质海量的数据“投喂”,才能培养出更聪明、更先进的版本。

iEnglish智能英语学习解决方案技术研发负责人贾先好表示,2018年GPT迭代使用了1.1亿学习参数,到2020年GPT-3已达到惊人的1750亿参数。“这些迭代的背后是45TB的海量文本数据,AI其实是一场包含海量学习参数在内的纯粹工程化的胜利。”

当下,全球各大科技公司发布的AI大模型已超数百个,而用于训练这些大模型的数据虽然海量但缺少精细“营养”,这也让快速迭代中的AI普遍都“吃”得不怎么好。

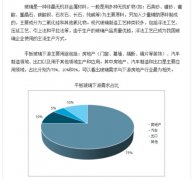

用户的数据“真香”

训练AI所需的海量数据,目前主要的来源包括互联网抓取的数据、网络百科全书、书籍文献,以及一些开源数据集等公开数据。但新壹科技技术副总裁陈鹏认为,这些数据仅有数量优势,而缺少让AI变得更聪明的高质量数据。“鉴于用户数据的多样性、真实性,以及个性化等特征,很多公司和机构会收集一定的用户数据来进行训练,提高AI模型的准确性和可靠性。”

“在AI训练中,普遍使用的RLHF(基于人类反馈的强化学习)技术就需要在迭代过程中不断根据人类反馈来优化自身行为,有助于提高机器在不同场景下的泛化能力,使其行为更加符合人类期望。”张文浩表示,RLHF技术在模仿学习阶段需要使用用户的交互数据来改进其策略,这也是优化用户体验的一种方式。

用户数据之所以被AI相中,是因为这些数据的内容非常丰富,基本上涵盖了各个领域和主题,正是AI训练所急需的“精料”。

训练AI要守“底线”

对于AI而言,用户数据确实很“美味”,但对于用户而言,过度的采集可能对个人信息安全和财产安全造成不小的威胁。

“用户数据用于训练AI时会被分析和解读,并揭示出用户诸如个人喜好、行为习惯、健康状况等隐私信息。”陈鹏表示,这些信息一旦被非法利用,就会导致用户身份盗窃、网络诈骗等情形的发生。

中国广告主协会互联网电商分会秘书长张俊良提醒,用户数据被“投喂”给AI,非常容易带来用户核心信息的泄漏。“所以,我们在使用大模型或者跟大模型交互时,尽量避免透露自己的隐私信息。”

用户数据可以用于AI训练吗?陈鹏认为,过度收集用户数据不可避免地会面临诸如隐私安全、数据合规性的挑战。“不过,现在行业内已经开始通过数据脱敏、加密技术和审计技术等来保护用户数据隐私了。”

贾先好表示,在数据的生产、保存、读取、更改、迁移、存档等生命周期内,AI企业应该采取相应的安全措施,以确保这些数据不会被未经授权的访问、篡改或者滥用。

其实,今年8月15日起实施的《生成式人工智能服务管理暂行办法》就明确,应当依法开展预训练、优化训练等训练数据处理活动,使用具有合法来源的数据和基础模型;涉及个人信息的,应当取得个人同意或者符合法律、行政法规规定的其他情形。

张文浩建议,各大科技公司应遵守相关法律法规,确保数据收集、处理和使用的合法性。“总之,企业在做AI训练时,应严格遵循个人数据使用‘最小化原则’,要守得住‘底线’。”

王超则认为,《生成式人工智能服务管理暂行办法》给国内AI产业指明了方向,也划定了范围。“但仅凭一部暂行办法并不能解决所有问题,AI是一次底层的技术革命,未来一定会碰到更多的问题,这就需要监管部门及时有效制定出监管措施,进一步规范产业的发展。”

秋冬静电太困扰?全棉时代新品面料来

秋冬静电太困扰?全棉时代新品面料来 投资打水漂 仿冒平台进行诈骗屡见不鲜

投资打水漂 仿冒平台进行诈骗屡见不鲜 难以启齿的尴尬 交给频私密仪!让你“

难以启齿的尴尬 交给频私密仪!让你“ 御尚新居轻钢别墅集节能环保、坚固耐

御尚新居轻钢别墅集节能环保、坚固耐

浅绛彩瓷板画双屏

浅绛彩瓷板画双屏 【艺术名家•共谱文脉传承】

【艺术名家•共谱文脉传承】 一生依世如何在市场中占领先机?

一生依世如何在市场中占领先机?